AI-accelerators: Desktop versus embedded

op

Kunstmatige intelligentie (Artificial Intelligence, AI) ontwikkelt zich snel en het kiezen van de juiste AI-accelerator is cruciaal. Laten we een paar belangrijke versnellers bekijken en hun functionaliteit en prestaties vergelijken, zodat we een weloverwogen beslissing kunnen nemen voor uw specifieke AI-behoeften.

De behoefte aan AI-accelerators

Waarom hebben we AI-accelerators nodig? Elke CPU of microcontroller kan, omdat hij turingcompleet is, exact dezelfde berekeningen uitvoeren als een AI-accelerator. CPU’s en microcontrollers voor algemeen gebruik zijn echter ontworpen voor een breed scala aan taken, en zijn daarom wellicht niet erg efficiënt voor specifieke AI-gerelateerde berekeningen.

Een AI-accelerator is een gespecialiseerde hardwarecomponent die ontworpen is om AI-taken te versnellen, en dan in het bijzonder de inferentiefase waarin AI-modellen voorspellingen doen op basis van nieuwe gegevens. In tegenstelling tot processoren voor algemeen gebruik, zijn AI-accelerators geoptimaliseerd voor het uitvoeren van grootschalige matrixbewerkingen en parallelle verwerking – essentieel voor taken als beeldherkenning, verwerking van natuurlijke taal en andere machine learning-toepassingen. Bij het uitvoeren van deze specifieke berekeningen zijn ze in vergelijking met standaard-CPU’s dan ook aanzienlijk efficiënter en sneller.

Naarmate AI zich verder ontwikkelt, heeft edge computing – het op lokale apparaten verwerken van gegevens in plaats van te vertrouwen op gecentraliseerde cloudservers – aan belang gewonnen. Deze verschuiving verbetert de real-time reactiesnelheid, privacy en algehele efficiëntie. Om in deze behoeften te voorzien, zijn er verschillende edge-AI-accelerators ontwikkeld voor zowel embedded systemen als PC’s.

Het kiezen van de juiste tool voor uw specifieke behoeften kan een uitdaging zijn, of u nu krachtige oplossingen nodig hebt voor complexe taken of lichtgewicht apparaten voor realtime taken in het veld. Laten we eens een blik werpen op enkele toonaangevende AI-accelerators, waarbij we hun functies, gebruikssituaties en prestaties belichten.

Waarom deze vergelijking?

Ik moet vaak enorme hoeveelheden gegevens verwerken voor toepassingen zoals spraak-naar-tekst transcriptie (bijvoorbeeld met Whisper ) en geautomatiseerde videobewerking en classificatie van archief-video’s. Voor deze taken zijn on-PC oplossingen met krachtige GPU’s zoals mijn NVIDIA RTX 4070 onmisbaar vanwege hun rekenkracht en flexibiliteit. Voor realtime detectietaken in het veld of in industriële omgevingen zijn embedded oplossingen zoals de Raspberry Pi AI Kit of Coral Dev Board daarentegen praktischer, gezien hun compacte formaat en geringere stroomverbruik. Deze vergelijking is bedoeld om de beste tools voor verschillende scenario’s te helpen identificeren.

Embedded edge AI-accelerators

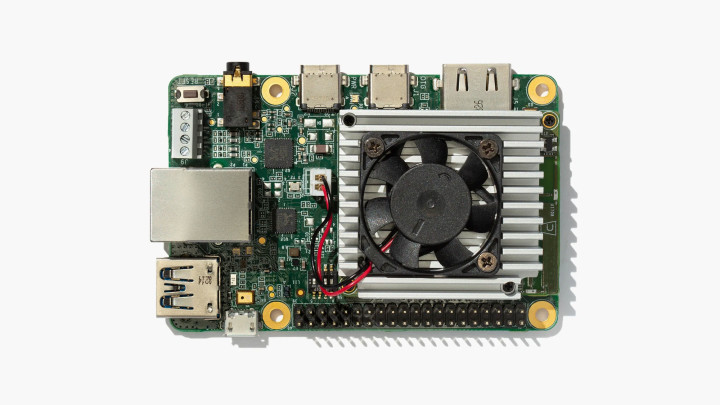

Raspberry Pi AI-kit met geïntegreerde Hailo-8L

De Raspberry Pi AI Kit is onlangs geïntroduceerd en brengt de Hailo-8L AI-accelerator naar de Raspberry Pi 5, waardoor krachtige AI-mogelijkheden mogelijk worden in een goedkope, compacte vormfactor. Het is een betaalbare oplossing om AI toe te voegen aan verschillende Raspberry Pi-projecten.

De Hailo-8L AI-accelerator wordt aangesloten op de M.2-aansluiting van de meegeleverde Raspberry Pi M.2 HAT+. Gemonteerd zoals in figuur 1, biedt hij 13 tera-bewerkingen per seconde (TOPS), waardoor hij geschikt is voor taken zoals real-time objectdetectie, semantische segmentatie, houdingsschatting voor het herkennen van gebaren, en gezichtsherkenning. Het geringe energieverbruik van de kit is ideaal voor batterijgevoede toepassingen en het compacte formaat past goed bij de officiële Raspberry Pi camera-accessoires. Hoewel hij niet zo krachtig is als sommige high-end NPU’s, is hij perfect voor lichte AI-taken, educatieve projecten en toepassingen in de hobby-sector.

Coral Dev Board

Het Coral Dev Board , geïntroduceerd in 2019, is ontworpen om TensorFlow Lite-modellen efficiënt uit te voeren als een stand-alone oplossing. Het bord heeft een Raspberry Pi-achtige vormfactor (figuur 2) en beschikt over een Edge TPU-coprocessor die 4 TOPS levert. Hij is uitstekend geschikt voor beeldclassificatie, objectdetectie en spraakherkenning, en dat maakt hem ideaal voor IoT-toepassingen. Het geringe energieverbruik is een belangrijk voordeel, vooral voor embedded systemen. Hij is echter voornamelijk beperkt tot TensorFlow Lite-modellen en biedt minder rekenkracht in vergelijking met sommige andere accelerators. Desondanks integreert hij naadloos met Google Cloud-services en levert hij efficiënte prestaties voor niet al te complexe AI-toepassingen in embedded systemen.

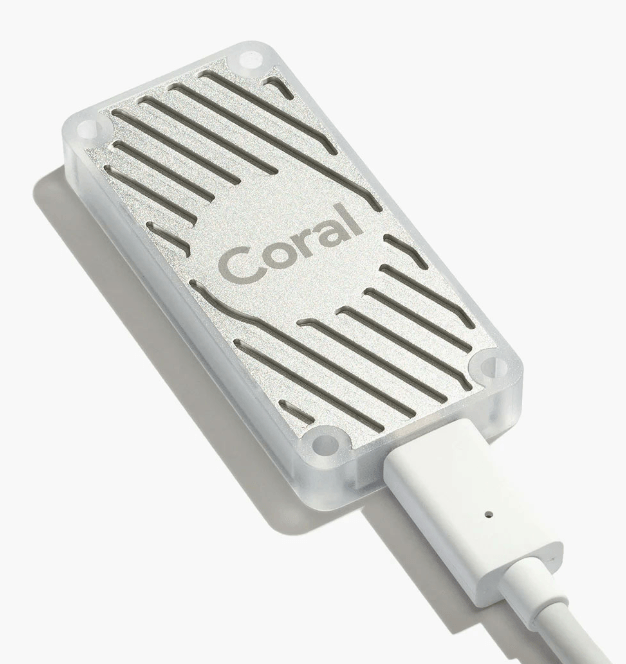

Coral USB Accelerator

Als u al een computerplatform bezit meer nog wat externe AI-power kunt gebruiken, is er de Coral USB Accelerator . Dit compacte apparaat, ongeveer zo groot als een standaard USB-stick (figuur 3), brengt de kracht van Edge TPU van Google naar elke compatibele computer via een USB 3.0-verbinding. Hij levert ook 4 TOPS aan prestaties bij een stroomverbruik van slechts 2 W. De USB Accelerator is ideaal voor ontwikkelaars die AI-mogelijkheden willen toevoegen aan bestaande systemen of prototypes willen maken van AI-toepassingen zonder een volledig development board te moeten aanschaffen. Hij blinkt uit in taken zoals beeldclassificatie en objectdetectie, waardoor hij een veelzijdige tool is voor AI-experimenten en kleinschalige implementaties.

NVIDIA Jetson

De Jetson-lijn van NVIDIA bestaat uit een reeks embedded computing boards die zijn ontworpen voor edge-AI-toepassingen. Dit ecosysteem omvat verschillende producten voor verschillende prestatiebehoeften en gebruiksscenario’s:

- Jetson Nano: het instapmodel, geschikt voor kleinere AI-projecten en prototypes.

- Jetson Xavier NX: een mid-range optie met aanzienlijk hogere prestaties dan de Nano.

- Jetson AGX Xavier: een krachtige module voor veeleisende AI-toepassingen.

- Jetson AGX Orin: de jongste en krachtigste telg van de familie, ontworpen voor geavanceerde robotica en autonome machines.

Deze modules variëren in rekenkracht, van 0,5 TOPS voor de Nano tot meer dan 200 TOPS voor de AGX Orin.

Alle Jetson-modellen draaien op NVIDIA’s JetPack SDK, die bibliotheken bevat voor deep learning, computer vision, accelerated computing en multimediaverwerking. Deze gemeenschappelijke softwareomgeving maakt schaling en implementatie binnen de Jetson-familie eenvoudiger.

De Jetson-lijn is zeer geschikt voor verschillende toepassingen, waaronder robotica, drones, intelligente videoanalyse en draagbare medische apparaten. De schaalbaarheid maakt het een veelzijdige keuze voor bedrijven die AI-toepassingen willen ontwikkelen en implementeren op verschillende prestatieniveaus.

Het instapmodel Jetson Nano (figuur 4), gelanceerd in 2019, bracht de AI-rekencapaciteit van het bedrijf naar kleine, betaalbare vormfactoren. Hij is uitgerust met een 128-core Maxwell GPU, een quad-core ARM Cortex-A57 CPU en 4 GB RAM, goed voor 472 GFLOPS (0,47 TOPS). De Jetson Nano is bijzonder geschikt voor kleine maar veeleisende AI-taken in embedded systemen. Hij kan meerdere neurale netwerken tegelijk aan, waardoor het een flexibele optie is voor verschillende AI-toepassingen. Het stroomverbruik is echter hoger dan bij andere embedded opties en de vormfactor is groter.

De Nano is een AI-module met een 260-pins edge connector, dus u kunt hem niet los gebruiken zonder hem ergens op aan te sluiten. Normaliter begint u met een Dev Kit, die u in de Elektor-shop kunt vinden.Voor meer informatie over de andere boards in de Jetson-serie verwijzen we naar de vergelijkingspagina van NVIDIA .

Intel Neural Compute Stick 2 (NCS2)

De Intel Neural Compute Stick 2 (NCS2), uitgebracht in 2018, is een andere draagbare USB-gebaseerde AI-accelerator . Met de Intel Movidius Myriad X VPU levert hij ongeveer 1 TOPS aan prestaties. Hij is ideaal voor AI-prototypes, onderzoek en het uitbreiden van bestaande PC’s met AI-mogelijkheden. De draagbaarheid en het gebruiksgemak maken hem tot een populaire keuze voor ontwikkelaars en onderzoekers. Hij is echter afhankelijk van een host-PC voor voeding en gegevensverwerking en biedt minder rekenkracht dan high-end GPU’s.

PC-gebaseerde edge-AI-accellerators

NVIDIA GPU’s

De NVIDIA RTX 4070 waarnaar hierboven wordt verwezen, maakt deel uit van de RTX 40-serie die in 2022 is uitgebracht. Het is een krachtpatser voor zowel gaming als professionele AI-toepassingen. Deze high-end GPU, beschikbaar op grafische kaarten van verschillende leveranciers, heeft 29,8 TFLOPS (29.800 GFLOPS) en 12 GB GDDR6-geheugen. Hij is perfect voor training en inferentie van grote neurale netwerken, krachtige gaming en het maken van content zoals videobewerking en 3D-rendering. De uitgebreide software-ondersteuning en uitzonderlijke rekenkracht maken hem ideaal voor veeleisende AI-toepassingen, waaronder spraak-naar-tekst transcriptie en videobewerking. Als uw budget het toelaat, kunt u overstappen op de RTX 4090 voor nog meer kracht, of sparen met een RTX 3080, die nog steeds aanzienlijke prestaties biedt. Het hoge energieverbruik en de hoge kosten maken hem echter meer geschikt voor grotere desktop-werkstations.

Met de RTX-serie, die NVIDIA’s slogan “the ultimate in ray tracing and AI” draagt, zitten we in het topsegment. Het nadeel kan zijn dat zodra u even wat anders gaat doen, andere gezinsleden beginnen te zeuren om de nieuwste FPS-game (first-person shooter) te mogen spelen met de hoge frame-rate die beschikbaar zijn op deze monsters.

Apple M-serie chips

Voor degenen die geïnvesteerd hebben in het Apple-ecosysteem: de M1-chip, aangeprezen als Apple’s eerste chip die speciaal is ontworpen voor de Mac, werd geïntroduceerd in 2020. De daaropvolgende M2-chip werd gelanceerd in 2022 en beide integreren AI-versnelling direct in de CPU. De M1-chip heeft een 8-core Neural Engine met 11 TOPS, terwijl de M2-chip een 16-core Neural Engine met 15,8 TOPS biedt. Deze chips zijn te vinden in apparaten zoals de MacBook Pro en Mac Mini, en bieden on-device AI-verwerking voor toepassingen zoals Siri, beeldverwerking en augmented reality. De naadloze integratie met macOS en iOS maakt deze chips zeer efficiënt voor AI-toepassingen op consumentenniveau, vooral voor degenen die geïnvesteerd hebben in het Apple-ecosysteem.

De M3, M3 Pro en M3 Max werden in 2023 aangekondigd, met verbeteringen over de hele linie. De M3-chips waren de eerste 3-nanometer chips en hadden een nieuwe GPU-architectuur die een snelheidsverhoging tot 30...50% mogelijk maakte ten opzichte van respectievelijk de M2 en M1. Met snellere CPU-prestaties, een efficiëntere Neural Engine en een next-generation GPU-architectuur die geavanceerde functies ondersteunt zoals dynamische caching en hardwareversnelde ray tracing, is de M3-serie bijzonder geschikt voor intensieve taken zoals high-end grafische verwerking, AI/ML workloads en complexe computertaken.

De inkt van de M3-aankondiging was nauwelijks droog toen Apple in mei 2024 de M4-chip aankondigde, maar deze is momenteel alleen beschikbaar in de iPad Pro van het bedrijf. Het zou interessant zijn om te zien of een derde ontwikkelaar een gebruiksscenario bedenkt om een dure iPad Pro te gebruiken voor een commerciële of industriële machine-learning taak.

Als u uw zware werk doet in het Apple-universum, zult u niet teleurgesteld zijn in een MacBook met een M2- of M3-chip voor uw AI-toepassingen. Welke chip u onder de motorkap hebt, hangt af van uw budget en uw toepassing.

Embedded versus PC-gebaseerd: wat te kiezen?

De keuze tussen embedded en PC-gebaseerde edge computing-oplossingen hangt grotendeels af van de specifieke vereisten van uw toepassing.

Embedded edge-AI

- Geschikt voor: zuinige realtime-toepassingen, waarbij grootte en stroomverbruik kritisch zijn, zoals smart home-apparaten, wearables en autonome sensoren.

- Voordelen: lager stroomverbruik, compact formaat, kosteneffectief.

PC-gebaseerde edge-AI

- Geschikt voor: toepassingen die veel rekenkracht en flexibiliteit vereisen, zoals desktop AI-toepassingen, complexe gegevensanalyse en het ontwikkelen en testen van AI-modellen.

- Voordelen: hoge prestaties, grotere flexibiliteit, mogelijkheid om complexere taken uit te voeren.

Wat te kiezen?

Embedded en PC-gebaseerde edge AI-oplossingen hebben elk hun unieke voordelen. Embedded accelerators zijn perfect voor realtime-toepassingen met een laag stroomverbruik, terwijl op werkstations/laptops gebaseerde oplossingen zoals NVIDIA RTX-gebaseerde GPU’s en Apple M-serie chips hoge prestaties bieden voor meer veeleisende taken. Door de sterke punten en beperkingen van elk te begrijpen, kunt u de juiste oplossing kiezen voor uw specifieke behoeften en de kracht van AI inzetten om slimmere, efficiëntere systemen te maken.

Dit vergelijkend overzicht is zeker niet volledig, maar het belicht een aantal van de meest populaire edge AI-accelerators die ik heb geprobeerd. Elk heeft zijn voor- en nadelen – het gaat erom die te kiezen die het beste past bij uw toepassing.

Het artikel, “2024 een AI Odyssey: Desktop Versus Embedded Accelerators” (230181-H-03), verschijnt in Elektor september/oktober 2024.

Discussie (0 opmerking(en))