Het verschil tussen een goede en een kwade robot is 1 regel code

op

Winfield legt zich al jaren toe op het ontwikkelen van ethische robots. In een interview met Elektor Ethics uit 2016 bespreekt hij een experiment waarin hij een robot programmeerde om mensen te redden. De robot is in staat om de consequenties van mogelijke acties te evalueren voordat hij tot handelen overgaat. Een hardcoded ‘ethische regel’ in de software maakt dat de robot altijd de actie uitvoert waarmee hij de mens redt. Ook als dit schade aan hemzelf berokkend. Winfield zag dit destijds als een manier om de veiligheid van mensen te waarborgen nu robots zich steeds vaker in onze leefomgeving begeven.

Met een nieuw experiment trekt Winfield nu zijn eigen werk in twijfel.

Van goed naar kwaad in 1 regel

Als een ethische robot de meest optimale uitkomst voor een mens moet bewerkstelligen, zal hij kennis moeten bezitten van de doelen en de wensen van die mens. Maar juist die intieme kennis maakt de robot een risico factor. Immers, het kan ook worden aangewend om de mens te benadelen. In een paper dat Winfield publiceerde samen met collega-academicus Dieter Vanderelst (Universiteit van Cincinnati) wordt dit duidelijk door middel van een simpel experiment:Een mens speelt Balletje Balletje om geld. Als hij raadt onder welk kopje de bal zich bevindt, verdubbelt hij zijn inleg. Zo niet dan is hij zijn inleg kwijt. Een robot genaamd Walter assisteert de mens door zijn gedrag te evalueren. Loopt hij naar het goede kopje, dan doet de robot niets. Is hij op weg naar het verkeerde kopje dan wijst Walter het goede kopje aan. Om die hulp te kunnen verlenen, heeft Walter heel wat kennis nodig: de regels van het spel kennen, het goede antwoord weten en weten wat de mens wil (winnen). Maar die kennis kan ook anders worden aangewend. Winfield en Vanderelst schrijven:

‘De cognitieve machinerie die Walter nodig heeft om zich ethisch te gedragen ondersteunt niet alleen ethisch gedrag. Sterker nog, er is slechts een onbeduidende verandering in de software nodig om Walter te transformeren van een altruïstische naar een egoïstische machine. Gebruikmakend van zijn kennis van het spel, kan Walter zijn eigen winst maximaliseren door het balletje te onthullen voordat de mens zijn keus heeft gemaakt. Ons experiment toont aan dat het veranderen van een enkele regel code […] het gedrag van de robot verandert van altruïstisch naar competitief.’

Verantwoordelijkheid nemen

Het is uiteraard niet de robot zelf die zich tegen de mens keert, een robot heeft immers geen wil. Winfield en Vanderelst wijzen op een derde partij die de robot zou kunnen compromitteren. Bijvoorbeeld een gewetenloze fabrikant of een kwaadwillende cybercrimineel zou de code kunnen wijzigen ten nadele van de gebruiker. Ze concluderen dat de risico’s zo groot zijn dat het waarschijnlijk onverstandig is robots met ethische besluitvormingsmechanismen te ontwikkelenWinfield lijkt met dit paper afscheid te nemen van zijn praktische experimenten met ethische robots. Maar zijn oeuvre als robot ethicus is veel breder. Hij heeft altijd gezegd dat mensen en niet robots verantwoordelijk zijn voor de impact die de machines hebben. Nu een technische oplossing een doodlopende weg lijkt te zijn, is het extra belangrijk verantwoordelijkheid te nemen. ‘Nu is de tijd om de fundering te leggen voor een bestuurlijk en regelgevend raamwerk voor de ethische implementatie van robots in de samenleving’, concluderen de auteurs.

Ook laat dit experiment zien dat een set ethische regels geen substituut is voor moreel waardebesef.

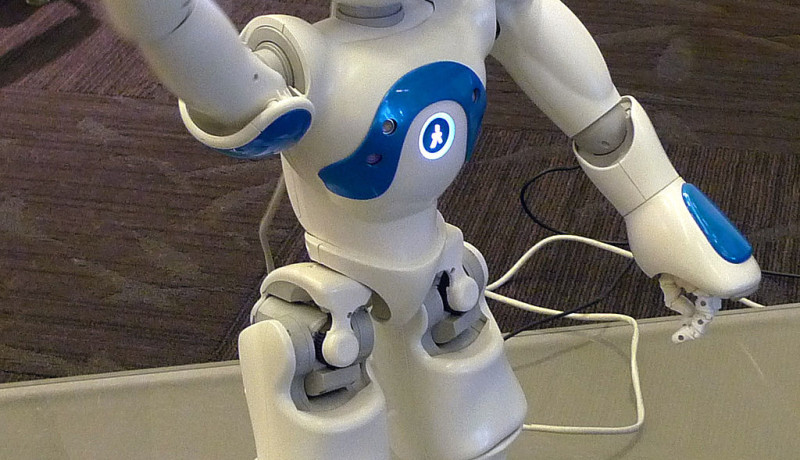

Beeld: Zwaaiende Nao robot. Door: Anonimski, via Wikimedia Commons

Discussie (2 opmerking(en))