The Machine heeft één geheugen... van 160 terabyte

23 mei 2017

op

op

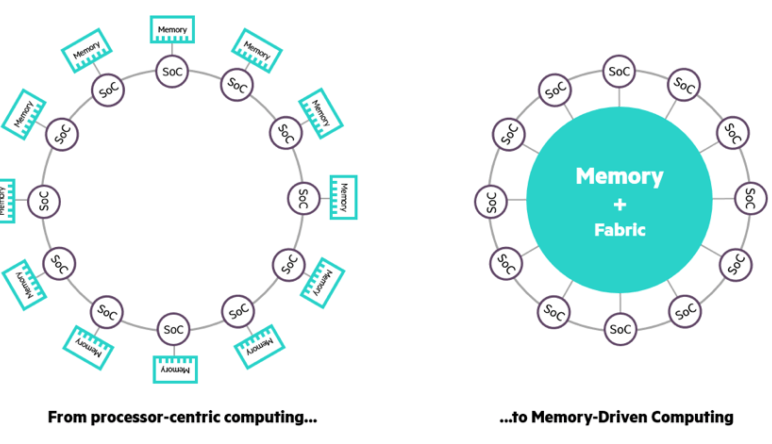

Ook al worden computers nog steeds elke dag sneller en sneller, ze hebben moeite met de enorme hoeveelheden data die wij produceren. Dat komt doordat deze computers nog steeds gebaseerd zijn op een architectuur die zo’n zestig jaren geleden is ontwikkeld. In die architectuur neemt de processor de centrale plaats in, het geheugen komt op de tweede plaats. Om dat op te lossen werken onderzoekers aan een nieuw rekenparadigma onder de naam Memory Driven Computing.

Bij Memory Driven Computing speelt het geheugen de centrale rol, de processor komt op de tweede plaats. Het idee is om één enorm aaneengesloten geheugen te delen tussen een groot aantal processors. Onderzoekers van HP hebben in november 2016 een eerste prototype van zo’n computer onthuld, dat ze “The Machine” hebben gedoopt, en nu kondigen ze een versie met 160 TB geheugen aan. En ze zijn niet van plan om het daarbij te laten, want ze denken dat ook een aaneengesloten geheugen van 4.096 yottabyte haalbaar is. (Dat is 250.000 maal het hele digitale universum van vandaag). The Machine is het grootste project dat ooit bij HP is uitgevoerd.

Illustratie: Bron: HPE

Bij Memory Driven Computing speelt het geheugen de centrale rol, de processor komt op de tweede plaats. Het idee is om één enorm aaneengesloten geheugen te delen tussen een groot aantal processors. Onderzoekers van HP hebben in november 2016 een eerste prototype van zo’n computer onthuld, dat ze “The Machine” hebben gedoopt, en nu kondigen ze een versie met 160 TB geheugen aan. En ze zijn niet van plan om het daarbij te laten, want ze denken dat ook een aaneengesloten geheugen van 4.096 yottabyte haalbaar is. (Dat is 250.000 maal het hele digitale universum van vandaag). The Machine is het grootste project dat ooit bij HP is uitgevoerd.

Illustratie: Bron: HPE

Read full article

Hide full article

Discussie (0 opmerking(en))